人工智能模型雖然理論上是機器運作,並無個人偏見,不過由於輸入作訓練的資料可能存在偏差,結果依然也是需要進一步檢查模型是否公平。LinkedIn 最近就將一個測試工具開源分享,讓社群有更多資源改善問題。

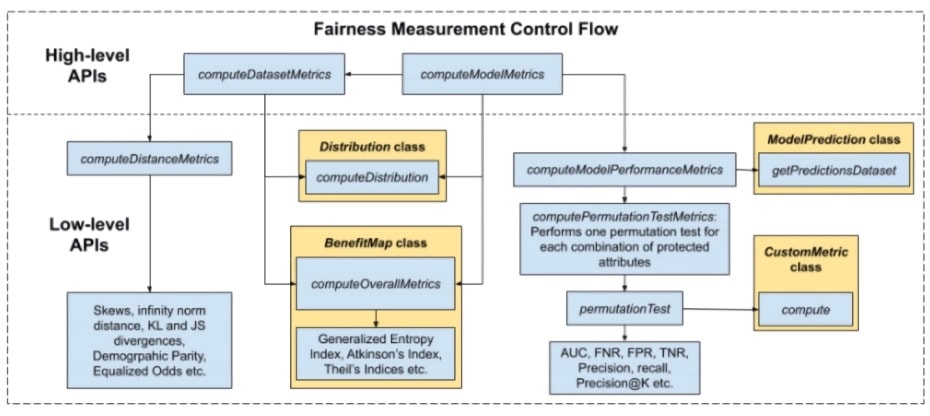

LinkedIn 最近開源的 Fairness Toolkit(LiFT)是個軟件庫,用於量度人工智能和機器學習流程的公平性。LinkedIn 表示,LiFT 可以在訓練和計分的時候使用,以測量訓練數據集中的偏差,並評估模型的公平性,同時檢測各個分組的性能差異。

LinkedIn 方面在網誌上表示,新聞和學術研究都強調,源於人類偏見的廣泛社會不公現象可能會反映在用於訓練 AI 模型的數據和模型本身之中,而研究還表明,受這些社會偏見影響的模型最終可能會加強這些偏見,並使對某些群體的歧視永久存在。而 LinkedIn 正努力透過避免模型中存在有害偏見並確保具有同等才華的人們平等地獲得工作機會,來建立一個更公平的平台。

來源:Venture Beat