有效的人工智能運算固然高效率,不過對我們而言,則很難理解到底它們是怎樣作出決定。MIT 最近一個研究,就讓人工智能用人類可以理解的方式,描述運算思考過程,使用家可以對人工智能系統有更多信任。

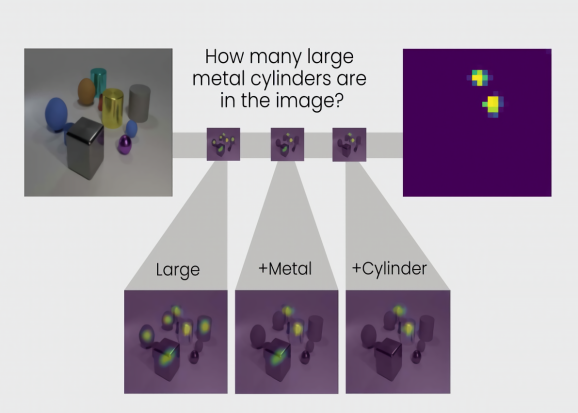

最近由 MIT 林肯實驗室情報和決策技術小組發表的一份學術報告《設計透明度:縮小視覺推理中效能與可解釋性之間的差距》中,研究人員描述了一個視覺分析系統,可以像人類般解釋計算出答案的推理步驟,令其運算過程更加透明。其神經網絡 TbD-net 透過熱力圖來進行視覺分析,在分析人類語言的問題後,拆分為不同的分析工作。當它分析一張照片的時候,會在有特徵的部分加上顏色標記,代表在哪部分有模組輸出去進行特定的工作。結果集合各區域的運算結果,組合成最終的答案。

系統雖然提供人類可以理解的運算過程顯示,其效能仍然相當優異。研究輸入了 85,000 個圖像和 850,000 條問題之後, TbD-net 的準確度達到 98.7%,被其他神經網絡運算方式更佳。

透過讓運算過程變得透明,研究人員相信可以讓用戶更信任系統,避免人工智能給人一種黑箱作業的感覺。這種措施特別在軍事和政府監控相關的系統中特別重要。IBM Research 的 AI 部門主管 Aleksandra Mojsilovic 表示,大型的人工智能系統有龐大的潛力去改變我們的生活,因此透明度問題一定要先予以解決,才可以讓人信任。

來源:VentureBeat