在語言模型訓練之中,左右其準確度和效能的元素自然是用於訓練的參數數量。最近 Google 推出新的語言模型,其參數數量高達 1.6 萬億,成為有史以來最大規模的語言模型。

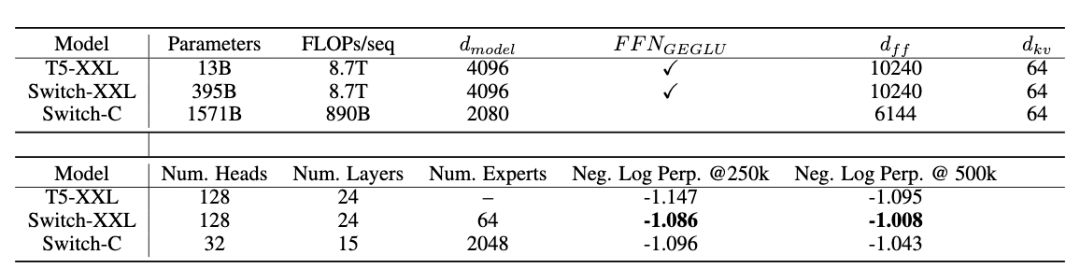

Google 新推出的語言模型稱爲 Swtich Transformer,並已經對之進行基準測試。開發者表示這個模型被之前最大型的 T5-XXL 模型效能提升四倍。他們強調,在開發強勁的模型上,透過大規模參數訓練是相當有效的途徑,也因此需要利用新的技術去支撐這個龐大的規模。

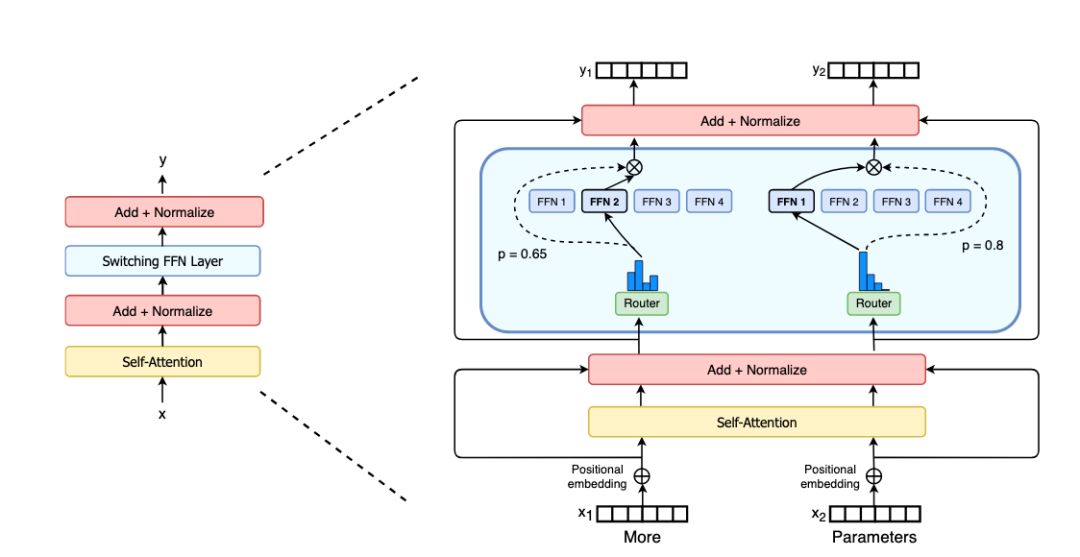

Google 研究人員表示,他們用了 Sparsely Activated 技術,以及簡化 Mix of Expert 設計,在處理極龐大的參數同時維持同樣的運算成本,有效利用以密集矩陣乘法設計的硬件優勢,提升訓練效率。

研究人員指出,Switch Transformer 未來將可以應用到不同的模態,例如圖像和文本分析,進一步擴充模型稀疏訓練方式的應用層面,希望這個成果可以讓稀疏模型成為更有效的架構,鼓勵研究人員在自然語言人工智能的開發上考慮採用這類模型。

來源:Venture Beat